Mistral AI lançou o Mistral Large 2, a versão mais recente do seu principal modelo de linguagem, que apresenta melhorias significativas na geração de código, matemática e capacidades multilíngues. O novo modelo, com 123 bilhões de parâmetros, possui uma janela de contexto de 128.000 tokens e visa desafiar os líderes do setor em desempenho e eficiência.

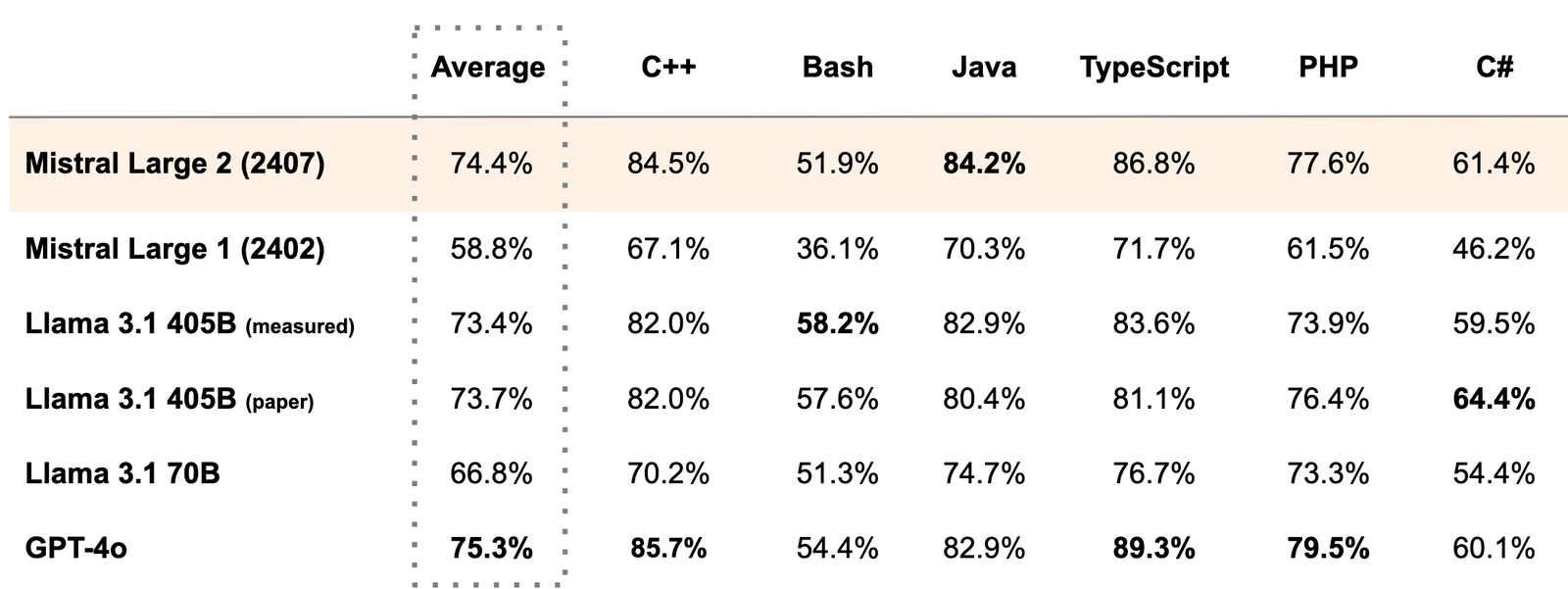

O Mistral Large 2 mostra desempenho impressionante em vários benchmarks. Em tarefas de geração de código, como HumanEval e MultiPL-E, ele supera o Llama 3.1 405B (lançado ontem pela Meta) e fica apenas abaixo do GPT-4. Em matemática, particularmente no benchmark MATH (resolução de problemas sem raciocínio em cadeia), o Mistral Large 2 é segundo apenas para o GPT-4o.

As capacidades multilíngues do modelo também receberam um impulso substancial. No benchmark multilíngue MMLU, Mistral Large 2 supera o Llama 3.1 70B base em média por 6,3% em nove idiomas e tem desempenho equiparável ao Llama 3 405B.

Apesar do seu grande tamanho, a Mistral AI projetou o modelo para inferência em um único nó, enfatizando a capacidade de processamento para aplicações de longo contexto. A empresa disponibilizou o Mistral Large 2 em sua plataforma, la Plateforme, e lançou os pesos para o modelo instrutivo no HuggingFace para fins de pesquisa.

Arthur Mensch, CEO da Mistral AI, afirmou: “O Mistral Large 2 estabelece uma nova fronteira em termos de relação desempenho-custo em métricas de avaliação.” Ele destacou que a versão pré-treinada alcança uma precisão de 84,0% no MMLU, estabelecendo um novo ponto na frente de Pareto desempenho/custo para modelos abertos.

O modelo passou por um treinamento extensivo em código-fonte, aproveitando a experiência da Mistral AI com modelos anteriores focados em código. Esse enfoque resultou em um desempenho comparável ao de modelos líderes como GPT-4, Claude 3 Opus e Llama 3 405B em tarefas de codificação.

A Mistral AI também se concentrou em aprimorar as capacidades de raciocínio do modelo e reduzir as alucinações. A empresa relata um desempenho aprimorado em benchmarks matemáticos, refletindo esses esforços.

Além disso, o Mistral Large 2 foi treinado para se destacar em tarefas de seguimento de instruções e conversação, com melhorias particulares no manejo de instruções precisas e conversas longas e multi-turnos.

O lançamento do Mistral Large 2 logo após o Llama 3.1 sinaliza uma competição intensificada no espaço dos modelos de linguagem de IA. Seu desempenho em áreas especializadas como geração de código e matemática, juntamente com um forte suporte multilíngue, posiciona-o como uma opção formidável tanto para pesquisa quanto para aplicações comerciais potenciais.

À medida que os modelos de IA continuam a crescer em tamanho e capacidade, o foco da Mistral AI em eficiência e inferência em um único nó destaca uma tendência importante no equilíbrio entre desempenho e considerações práticas de implantação.