Com a integração de tecnologias hápticas avançadas, os ambientes imersivos do metaverso e a aplicação de inteligência artificial (IA), estamos agora na vanguarda de uma era em que vídeos e hologramas ultrapassam a barreira da tela. Essa sinergia tecnológica permite que usuários interajam com objetos nas cenas digitais de maneira tátil, efetivamente podendo “tocar” e sentir o conteúdo virtual. Isso é possível graças à capacidade da IA de gerar mapas de profundidade detalhados em imagens e vídeos, criando uma simulação realística de espaços tridimensionais. Adicionalmente, com as inovações contínuas no metaverso, essas experiências interativas e táteis estão se tornando mais acessíveis e ricas, marcando uma nova fase na interação humano-computador.

Primeiramente, o processo inicia com a divisão do vídeo em frames individuais, que são posteriormente processados por um algoritmo de deeo learning. Este algoritmo é responsável por avaliar meticulosamente cada pixel dos frames para estimar sua profundidade, levando em consideração fatores como dimensão e formato dos objetos, nuances de iluminação e padrões de movimento. Através da síntese dessas estimativas, um mapa de profundidade coerente é gerado para o vídeo completo. Esse mapa é a chave para renderizar o vídeo de forma a emular a percepção tridimensional, conferindo-lhe um efeito 3D convincente. Para garantir precisão e realismo, o algoritmo é treinado utilizando um vasto conjunto de dados que abrange vídeos detalhados de pessoas, objetos diversos e ambientes naturais, permitindo-lhe aprender e reconhecer uma ampla gama de profundidades espaciais. Abaixo um exemplo do vídeo processado e renderizado.

Esta técnica é denominada “Video Depthify”, refere-se à criação de uma sensação tridimensional ao atribuir valores de profundidade a cada pixel ou região de um vídeo. O objetivo é fazer com que os objetos pareçam ter profundidade real e relações espaciais uns com os outros, ao invés de parecerem planos.

Para que um modelo de machine learning possa “depthify” vídeos, ele primeiro precisa ser treinado em um grande conjunto de dados, assim posteriormente permitindo que o modelo aprenda a relação entre os pixels do vídeo e os valores de profundidade correspondentes.

Redes Neurais Convolucionais (CNNs): As CNNs são usadas nesse tipo de tarefa, pois são particularmente boas em tarefas relacionadas à imagem e vídeo. Elas podem identificar características e padrões em imagens que correspondem a diferentes níveis de profundidade.

Estimação de profundidade monocular é uma técnica que tenta derivar mapas de profundidade de imagens ou vídeos de uma única lente. Isso é particularmente desafiador, mas com conjuntos de dados suficientes e modelos complexos, tornou-se viável “depthify” vídeos que foram gravados sem qualquer equipamento especializado de profundidade.

Hardware 3D

Atualmente, a geração de vídeos com profundidade alcançou um patamar notavelmente avançado graças à utilização de câmeras 3D inovadoras, como a Intel RealSense e a OAK-D, que capturam dados espaciais com grande precisão. Estas câmeras são equipadas com sensores de profundidade sofisticados, que mapeiam o ambiente em três dimensões em tempo real, fornecendo uma nuvem de pontos densa e informações detalhadas sobre a forma e o posicionamento dos objetos no espaço. Combinando esses dados ricos com algoritmos inteligentes, é possível criar vídeos que não apenas exibem imagens com aparência tridimensional, mas que também permitem interações profundamente imersivas e aplicativos avançados em realidade aumentada, robótica e além, revolucionando como interagimos e percebemos conteúdo digital em três dimensões. Um exemplo, é o projeto que desenvolvi para projetar hologramas com câmeras realsense https://github.com/cabelo/rscreatelg .

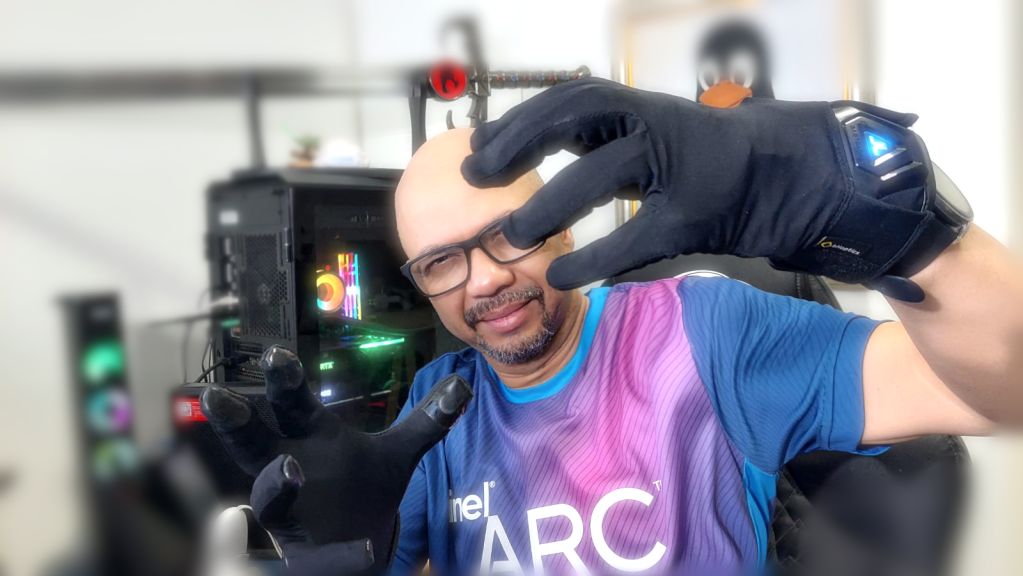

Luvas com tecnologia háptica

As tecnologias táteis, como o TactGlove da bHaptics, são dispositivos inovadores que buscam melhorar a imersão em ambientes virtuais e digitais através da simulação de sensações táteis.

Funcionam com atuadores e Mapeamento de Sensações: O TactGlove, e dispositivos similares, são equipados com uma série de atuadores distribuídos ao longo da superfície da luva (por exemplo, um luva). Estes atuadores são pequenos motores ou módulos que podem vibrar ou se mover de maneiras específicas. Quando ativados, eles recriam a sensação de toque, pressão ou até mesmo movimento na pele do usuário, imitando a sensação de estar tocando ou sendo tocado por objetos virtuais.

Esses dispositivos táteis são conectados a sistemas de realidade virtual (VR) ou realidade aumentada (AR). Quando um usuário interage com um objeto virtual ou experimenta um evento no ambiente digital (como ser atingido por um objeto), o sistema envia informações para o dispositivo tátil. Baseando-se nessa informação, o dispositivo ativa os atuadores apropriados para simular a sensação correspondente.

Quando se utiliza inteligência artificial para gerar um vídeo com tecnologia Depthify, o sistema consegue calcular precisamente as coordenadas relativas dos objetos virtuais dentro do vídeo em relação ao ambiente real. Essa habilidade de “entender” a posição espacial permite, então, ativar os mecanismos hápticos de uma luva especializada, como a vibração, no exato momento em que uma colisão entre pontos tridimensionais é detectada. Desta forma, o usuário pode experimentar uma resposta tátil sincronizada com a interação visual, intensificando a imersão e proporcionando uma experiência de realidade mista convincente e interativa.

Abaixo um exemplo da tecnologia em prática. Resumidamente o futuro chegou!