Inference v0.9.18 é uma plataforma de código aberto projetada para simplificar o processamento modelos de visão computacional. Ela permite que desenvolvedores realizem detecção de objetos, classificação e segmentação de instâncias, além de utilizar modelos de base como CLIP, Segmentação e YOLO-World através de um pacote nativo Python, este software é um servidor de inferência auto-hospedado ou uma API totalmente gerenciada.

Com isto é possível executar múltiplas transmissões de vídeo através de um único pipeline, aplicações para monitorar a eficiência de lojas de varejo, detecção de objetos pequenos e muito mais.

Com esta versão tornou possível processar múltiplos vídeos e transmissões usando um pipeline. Com múltiplas transmissões em um pipeline, você pode simplificar sua arquitetura de serviço de modelo e trazer transmissões de várias câmeras de borda para um único pipeline para processamento em uma única GPU. Essa configuração é ideal para ambientes de fabricação que operam múltiplas linhas em um único local para garantir que a produtividade permaneça alta enquanto reduz o hardware necessário para executar o processamento na borda.

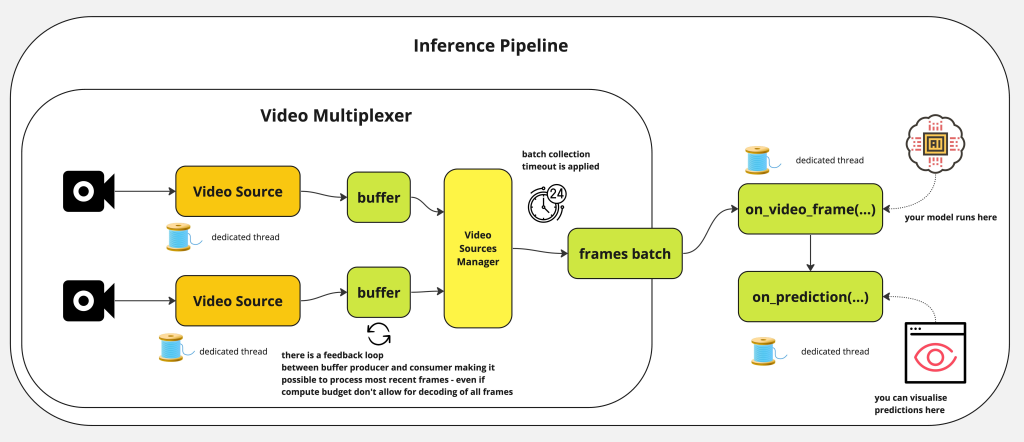

Como funciona o InferencePipeline?

InferencePipeline gira uma thread consumidor de fonte de vídeo para cada referência de vídeo fornecida. Quadros dos vídeos são capturados por um multiplexador de vídeo que espera por um timeout de coleta de lote (se a fonte não fornecer um quadro, um lote menor será passado para on_video_frame, mas quadros ausentes e previsões serão preenchidos com None antes de passar para on_prediction . O on_prediction pode trabalhar no modo SEQUENCIAL (apenas um elemento de cada vez), ou no modo LOTE – todos os elementos do lote ao mesmo tempo, e isso pode ser controlado pelo parâmetro sink_mode.

Para arquivos de vídeo estáticos, InferencePipeline processa todos os quadros por padrão, para transmissões – é possível descartar quadros dos buffers – em favor de sempre processar os dados mais recentes (quando a inferência do modelo é lenta, mais quadros podem ser acumulados no buffer – o processamento de transmissão descarta quadros mais antigos e só processa o mais recente).

Para aumentar a estabilidade, no caso de processamento de transmissões – as fontes de vídeo serão automaticamente reconectadas uma vez que a conectividade for perdida durante o processamento. Isso é destinado a prevenir falhas em ambiente produtivo quando o pipeline pode funcionar por longas horas e precisa lidar de forma graciosa com tempos de inatividade das fontes.

Mais informações no github: https://github.com/roboflow/inference