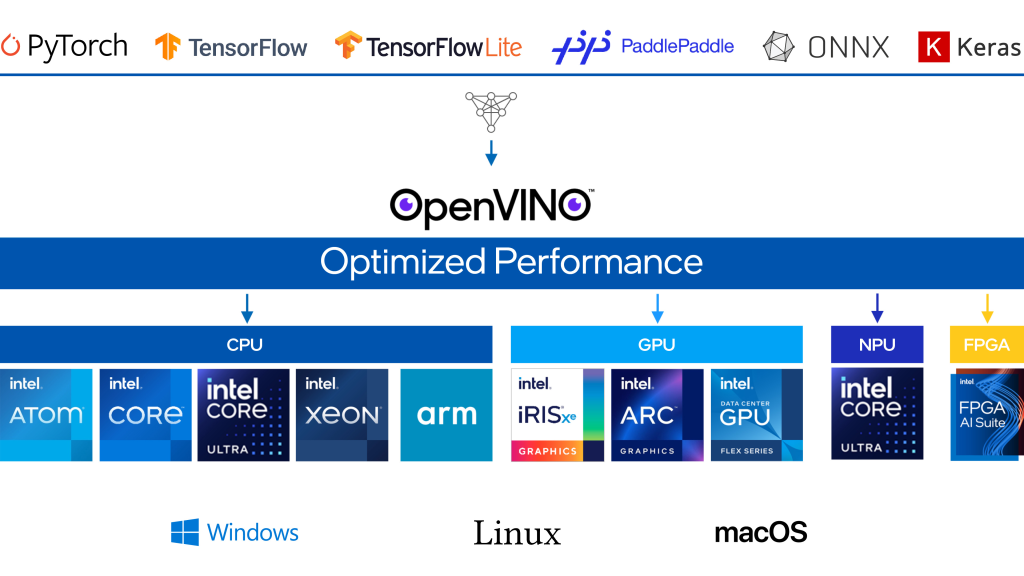

OpenVINO é um kit de ferramentas de código aberto para otimizar e implantar modelos de aprendizagem profunda da nuvem até a borda. Ele acelera a inferência de aprendizado profundo em vários casos de uso, como IA generativa, vídeo, áudio e linguagem com modelos de estruturas populares como PyTorch, TensorFlow, ONNX e muito mais. Converta e otimize modelos e implante em uma combinação de hardware e ambientes Intel®, no local e no dispositivo, no navegador ou na nuvem.

- Maior cobertura de IA generativa e integrações de frameworks para minimizar mudanças no código.

- Modelos Mixtral e URLNet otimizados para melhorias de desempenho em processadores Intel® Xeon®.

- Modelos Stable Diffusion 1.5, ChatGLM3-6B e Qwen-7B otimizados para velocidade de inferência aprimorada em processadores Intel® Core™ Ultra com GPU integrada.

- Suporte para Falcon-7B-Instruct, um modelo de chat/instrução de Large Language Model (LLM) da GenAI pronto para uso com métricas de desempenho superiores.

- Novos Jupyter Notebook adicionados: YOLO V9, Detecção de Caixas Delimitadoras Orientadas YOLO V8 (OOB), Stable Diffusion em Keras, MobileCLIP, RMBG-v1.4 Remoção de Fundo, Magika, TripoSR, AnimateAnyone, LLaVA-Next, e sistema RAG com OpenVINO e LangChain.

- Suporte mais amplo para Large Language Model (LLM) e mais técnicas de compressão de modelos.

- Tempo de compilação do LLM reduzido através de otimizações adicionais com incorporação comprimida. Desempenho aprimorado do primeiro token dos LLMs nas 4ª e 5ª gerações de processadores Intel® Xeon® com Extensões Avançadas de Matriz Intel® (Intel® AMX).

- Melhor compressão do LLM e desempenho aprimorado com suporte oneDNN, INT4 e INT8 para GPUs Intel® Arc™.

- Redução significativa de memória para modelos GenAI menores selecionados em processadores Intel® Core™ Ultra com GPU integrada.

- Mais portabilidade e desempenho para executar IA na borda, na nuvem ou localmente.

- O plugin NPU de prévia para processadores Intel® Core™ Ultra agora está disponível no repositório GitHub de código aberto OpenVINO, além do pacote principal OpenVINO no PyPI.

- A API JavaScript agora está mais acessível através do repositório npm, permitindo aos desenvolvedores de JavaScript acesso sem interrupções à API OpenVINO.

- Inferência FP16 em processadores ARM agora habilitada por padrão para a Rede Neural Convolucional (CNN).